Prevedere non significa comprendere

Il nostro Marco Dal Pozzo ci regala una sua nuova riflessione sul concetto di “trasparenza degli algoritmi”. Lo studioso spulciando come al solito dentro alcuni articoli e saggi inerenti al tema recentemente pubblicati, prova ad allargare il contenuto delle elaborazioni di altri esperti, per distillare un suo specifico ragionamento che riporti l’attenzione del lettore sul tema, a suo e nostro avviso, centrale nella cosiddetta: “società degli algoritmi” come noi stessi abbiamo più volte definito il nostro consesso sociale.

Il nostro Marco Dal Pozzo ci regala una sua nuova riflessione sul concetto di “trasparenza degli algoritmi”. Lo studioso spulciando come al solito dentro alcuni articoli e saggi inerenti al tema recentemente pubblicati, prova ad allargare il contenuto delle elaborazioni di altri esperti, per distillare un suo specifico ragionamento che riporti l’attenzione del lettore sul tema, a suo e nostro avviso, centrale nella cosiddetta: “società degli algoritmi” come noi stessi abbiamo più volte definito il nostro consesso sociale.

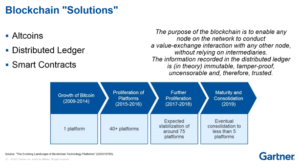

E’ ormai noto che il GDPR permette la portabilità dei dati personali. Antonello Soro – riporta Luca De Biase in un recente articolo su Nova 24 – puntualizza che: “Lo scopo della portabilità dei dati è quello di aprire il mercato e mettere in gioco della alternative”. Luigi Zingales, poi – sempre nel pezzo “Il mercato dei dati personali” a firma De Biase – ponendo la questione dell’eventuale necessità di regolare o meno le piattaforme, pensa ad una soluzione per cui l’interoperabilità sia opportunamente incentivata.

La soluzione che De Biase propone nel suo “Crossroads” è quella di Viktor Mayer-Schönberger, autore di “Reinventing Capitalism in the Age of Big Data”: “le imprese devono essere obbligate a condividere una parte dei loro dati con altre imprese che non ne hanno abbastanza per competere: in cambio avranno una piccola riduzione del carico fiscale. I dati devono essere anonimizzati. E selezionati casualmente dall’insieme dei dati raccolti dai giganti”.

Sembra strano che, nonostante una ottima premessa (ancora Mayer-Schönberger: “Il problema è che nell’economia dei dati, chi ne detiene molto più degli altri finisce per possedere algoritmi e sistemi di machine learning molto meglio allenati”), poi non si affondi il colpo: la questione centrale è proprio l’algoritmo: la protezione offerta dall’anonimizzazione è poco più che una etichetta quando il detentore dei dati non è protetto (in termini di consapevolezza, se non di completa trasparenza) anche e soprattutto dagli effetti dell’algoritmo che li macina.

Michele Mezza, nel suo volume “Algoritmi di Libertà “, spiega bene la questione con l’esempio paradigmatico di Spotify amplificando gli argomenti posti qualche anno fa da Eli Pariser: “Spotify – dice Mezza – gioca a curling con ognuno di noi, grazie ai suoi algoritmi predittivi, eliminando l’attrito che devia la nostra rotta. Si tratta, di fatto, di una learning machine applicata alla crescita dei gusti, dunque della personalità e delle relazioni, di ognuno dei suoi utenti, che impara e prevede le caratteristiche dei gusti in base a una poderosa massa di dati raccolti su ogni fattore che incide sulla nostra vita, e, giocando sulle correlazioni, le assonanze e somiglianze dei comportamenti di milioni individui simili in ambienti simili, arriva a determinare schemi di evoluzione.” Schemi che, come aveva dimostrato la rassegna di Cathy O’Neil nel suo “Armi di distruzione matematicaâ€,  trovano applicazione in ogni ambito della nostra esistenza (esiste l’algoritmo per accedere agli studi, l’algoritmo per attribuire punteggi agli insegnanti, l’algoritmo per regolare l’orario di lavoro, l’algoritmo che stabilisce la affidabilità per l’accesso al credito, etc…).

Non è quindi l’anonimizzazione del dato a salvare gli individui dagli effetti dell’algoritmo predittivo. Algoritmo che, “nel gioco delle correlazioni, delle assonanze e delle somiglianze di comportamenti di milioni di individui in ambienti simili” e – per citare ancora Mezza – nel suo essere concepito dal suo proprietario (il dirigente scolastico, il proprietario di Just Eat, Foodora o Uber, il direttore di banca) come: “ultimo strumento di una volontà di primato di alcuni uomini sulla stragrande maggioranza di esecutori”, decidono che uno studente non può accedere ad un corso, che un insegnante deve perdere il suo posto, che bisogna guidare dodici ore al giorno o che è accettabile il rischio di perdere una gamba, che non si può accendere un mutuo in banca.

Del resto ci sono esempi pratici sull’uso, l’abuso o anche la ripetuta violazione e messa alla berlina dei sistemi algoritmici che dimostrano, come direbbero in un’aula di tribunale negli States (o forse solo in un episodio di un legal drama tv) : “oltre ogni ragionevole dubbio” la fondatezza del ragionamento del nostro Marco Dal Pozzo. Proviamo a vederne alcuni così come sono stati indagati, scovati, segnalati e riportati nella rubrica digit segnali dalla nostra Claudia Dani.

Ad esempio:  questo algoritmo sa come voterai in base all’auto che guidi

I ricercatori hanno creato un algoritmo in grado di identificare le auto direttamente su Google Street View per avere un rilevamento accurato e molto  più rapido ed economico

Gli scienziati “hanno addestrato†i loro algoritmi a riconoscere la marca, il modello e l’anno di ogni auto viste in 50 milioni di immagini da 200 diverse città degli USA su Google Street View. Questo dato è stato a sua volta confrontato con un database demografico chiamato American Community Survey e i dati di voto sulle ultime elezioni presidenziali. I risultati sono stati infine pubblicati in PNAS.

I dati dell’auto sono stati confrontati con le informazioni demografiche e sono state fatte “forti associazioni tra distribuzione dei veicoli e fattori socio-economici disparatiâ€, scrivono i ricercatori. Gli abitanti dei quartieri con una grande popolazione asiatica si sono dimostrati più propensi a guidare Honda e Toyota; Le popolazioni delle aree afro-americane sono state  associate a Chrysler, Buick e Oldsmobile, mentre camioncini, Volkswagen e Aston Martin sono stati attribuiti con buona approssimazione ai residenti dei quartieri prevalentemente popolati da caucasici.

I ricercatori affermano che questo tipo di lavoro non è destinato a sostituire i sondaggi porta a porta molto  più laboriosi ma decisamente più accurati, ma potrebbe contribuire a completarli e ad accelerare le procedure per il raggiungimento dei risultati.

Secondo gli scienziati: “le previsioni del documento sono applicabili solo a livello di gruppo e  potrebbero esserci tecniche più accurate. Gli autori guardano ad un livello aggregato dei dati piuttosto che a un livello individuale, come ad esempio accade nell’atteggiamento di voto rispetto ai dati derivanti dall’applicazione di uno specifico   codice di avviamento postale di zona o di circoscrizione piuttosto che i dati raccolti da un singolo individuo. Anche in termini di accuratezza, i risultati non sono così buoni. Un buon indicatore, per gli esperti, potrebbe emergere, confrontando i dati raccolti con la proporzione del voto di un distretto messa in luce dopo l’ultima votazioneâ€.

Per determinare quali prodotti potrebbero piacere a un cliente , cercano altri clienti che hanno dato valutazioni simili a una gamma di prodotti simili ed estrapolano questi specifici prodotti in una lista ad hoc.

Il successo di questo tipo di approccio dipende in modo particolare da quella che viene definita: “nozione di somiglianzaâ€.

La maggior parte dei sistemi di raccomandazione utilizza una misura chiamata similarità del coseno, che sembra funzionare bene nella pratica. L’anno scorso, alla conferenza sui sistemi di elaborazione delle informazioni neurali, i ricercatori del MIT hanno utilizzato un nuovo quadro teorico per dimostrare perché, effettivamente, la similarità del coseno produce risultati così buoni.

Un nuovo algoritmo di raccomandazione che dovrebbe funzionare meglio di quelli in uso oggi, in particolare quando i dati di classificazione sono “sparsi†– cioè, quando c’è poca sovrapposizione tra i prodotti recensiti e le valutazioni assegnate dai diversi clienti.

La strategia di base dell’algoritmo è semplice: quando si tenta di prevedere la valutazione di un cliente riguardo un particolare prodotto, bisogna utilizzare non solo le valutazioni di persone con gusti simili alle nostre, ma anche le valutazioni di persone che sono simili a quelle persone e così via a scendere allargando sempre di più il campione.

L’idea è intuitiva, ma in pratica tutto dipende ancora dalla misura specifica della somiglianza.

Ma anche: come gli studenti del MIT hanno imbrogliato un algoritmo di Google

Questo nuovo modo di ingannare l’intelligenza artificiale potrebbe essere un affare più grande di quanto si possa pensare.

Negli ultimi anni, i ricercatori hanno dimostrato che un tipo di algoritmo chiamato classificatore di immagini – si pensi ad esso come a un programma a cui è possibile mostrare un’immagine di un animale domestico, ed esso rivelerà se si tratta di  un cane o un gatto – può essere vulnerabile. Questi programmi risultano suscettibili agli attacchi di qualcosa che potremmo chiamare “adversarial examples†“esempi contraddittoriâ€.

Un gruppo di studenti del MIT ha dimostrato di essere in grado di creare oggetti tridimensionali capaci di creare errori di classificazione degli algoritmi, mostrando che gli adversarial examples siano una minaccia reale.

È una modalità di attacco efficiente e potrebbe rendere più facile chi non ha buone intenzioni di ingannare qualsiasi classificatore di immagini.

“Non è l’anonimizzazione del dato a salvare gli individui dagli effetti dell’algoritmo predittivo”, come sottolinea Marco Dal Pozzo a conclusione della sua riflessione, serve, permetteteci di aggiungere, consapevolezza, conoscenza e soprattutto è necessario che nella costruzione di ciascun algoritmo venga inserita una clausola obbligatoria di “trasparenza”. E per chiudere aggiungendo ancora utili notizie sul tema attingiamo ancora una volta agli approfondimenti di Claudia Dani sul mondo degli algoritmi riportando l’interessante iniziativa assunta dal Comune di una cittadina degli Stati Uniti, avete presente New York City?

TechCrunch riporta che la città di NY ha deciso di istituire una task force che monitorizzi,  o meglio controlli, gli algoritmi utilizzati dalle istituzioni locali. Lo spunto interessante qui sta nelle raccomandazioni che la task force dovrebbe dare, che ci paiono fondamentali, nell’ambito di un processo  democratico.

L’unità sarà formata da esperti di sistemi automatizzati (algoritmi) e rappresentanti di gruppi interessati da tali sistemi (avvocati, poliziotti, ecc.) e dovrà esaminare attentamente gli algoritmi utilizzati e fornire indicazioni su come migliorare il loro uso ed evitare pregiudizi.  (confidiamo che ci siano anche i giornalisti in questa squadra, ci permettiamo di aggiungere)

la task force suggerirà raccomandazioni riguardanti:

- In quale modo le persone possono sapere se loro, o le loro azioni, verranno valutate da un algoritmo e come informare le persone su tale procedimento

- comprendere se un determinato algoritmo possa falsificare le comunicazioni prodotte a beneficio di alcuni gruppi sociali specifici, come gli anziani, gli immigrati, i disabili, le minoranze, ecc.

- In caso affermativo, che cosa potrebbe essere fatto a nome del gruppo coinvolto nell’azione pregiudizievole per renderla trasparente

- Come funziona un determinato algoritmo, sia in termini più tecnici che di modalità di applicazione

- Come devono essere documentati e archiviati questi sistemi e in che modo apprendono

Per chi avesse voglia di approfondire,  qui trova il testo integrale del provvedimento emesso dalla città di New York.