Les Echos si lanciano nel web semantico con un ‘’aggrefilter’’

Aggregazione e filtraggio. Si basa su queste due funzioni il sistema che LesEchos ha lanciato oggi in beta e che porta il gruppo editoriale francese ad applicare il web semantico al settore dell’ informazione economica. ‘’Ecco come abbiamo fatto. E perché’’, spiega Frédéric Filloux, nella sua Mondaynote.

Aggregazione e filtraggio. Si basa su queste due funzioni il sistema che LesEchos ha lanciato oggi in beta e che porta il gruppo editoriale francese ad applicare il web semantico al settore dell’ informazione economica. ‘’Ecco come abbiamo fatto. E perché’’, spiega Frédéric Filloux, nella sua Mondaynote.

Un esperimento di grande interesse anche perché mostra la – ormai ineludibile – necessità per l’ editoria di un lavoro congiunto di giornalisti e ingegneri informatici.

Building a business news aggrefilter

di Frédéric Filloux

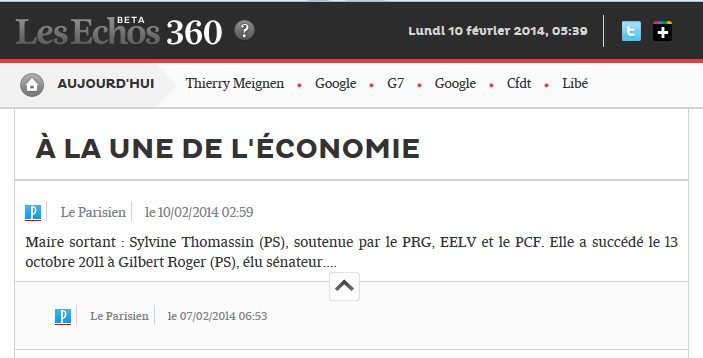

Il sito si chiama Les Echos 360 ed è separato dal sito-ammiraglia, LesEchos.fr, versione digitale del quotidiano economico francese. Come indica il termine di nuovo conio,  ‘’aggrefilter’’ è soprattutto un sistema di aggregazione e filtraggio. Speriamo che possa essere il punto da cui prenderanno forma una serie di prodotti digitali e di estensioni che abbiamo in mente.

La mia idea di costruire un aggrefilter risale al … 2007. Quell’ anno, a San Francisco, avevo incontrato Dan Farber , all’ epoca redattore capo di CNet (ora è a CBS Interactive, il suo blog è qui) – e vero padre del termine. Dan mi disse: ‘’Dovresti dare un’ occhiata a Techmeme . E’ un ‘aggrefilter’ che raccoglie notizie di tecnologia e le classifica in base alla loro importanza all’ interno del ciclo dell’ informazione’’. Avevo cercato per un po’ di tempo di provare a costruire uno strumento del genere, ma mi sembrava troppo complicato farlo partendo da zero, senza avere fra le mani nessun programma adatto. Ci sarebbe stato bisogno di qualcuno come il fondatore di Techmeme, Gabe Rivera – un grosso esperto e studioso di informatica. E quindi avevo accantonato l’ idea per un po’.

Un anno fa , come responsabile del settore digitale a Les Echos, ho ripreso l’ idea e l’ ho sottoposta a un paio di esperti informatici francesi specializzati nel text-mining, un campo che ha avuto recentemente un grosso sviluppo. E quindi abbiamo deciso di realizzare il progetto. Perché ?

Credo che un grande gruppo editoriale, una testata caratterizzata da una serie di attributi positivi come l’ affidabilità e la capacità di approfondimento, debba generare un’ impronta editoriale che vada ben oltre la propria produzione. E ‘una questione di massa critica. Nel caso di Les Echos , dobbiamo essere il vero nucleo dell’ informazione economica, sia per il grande pubblico che per le aziende . I lettori si fidano dei contenuti che produciamo e quindi dovrebbero fidarsi anche delle indicazioni di lettura che diamo attraverso il nostro lavoro di aggregazione di siti web rilevanti. Non si tratta di una mossa scontata per una struttura giornalistica che, ovviamente, non è di solito interessata a inviare traffico verso siti web di terzi. (Un collega del New York Times mi ha raccontato che qualche anno fa si era svolto un acceso dibattito all’ interno della redazione: in che misura il NYT doveva suggerire ai lettori materiali dei concorrenti (attraverso dei link verso fonti esterne, ndr). Delle analisi di mercato però avevano risolto la questione  dimostrando che ai lettori del New York Times on-line in realtà quella cosa piaceva perché si trattava di indicazioni affidabili.

In campo economico, a differenza di Google News che setaccia un numero illimitato di fonti, la mia idea originale era quella di estrarre delle buone storie di tema economico da una serie di fonti selezionate sia attraverso algoritmi che manualmente. Cosa ancora più importante, l’ idea era di portare alla superficie, di seguire in maniera efficace delle fonti specializzate – siti web e blog di nicchia – i cui materiali di solito vengo persi nel rumore di fondo della Rete. Sembrava essenziale anche l’ aspetto del flusso di notizie ‘’quasi in tempo reale’’ e da qui l’ idea di realizzare un processo di raccolta di notizie automatizzato, in stile Techmeme (che ora è stata rafforzata con Mediagazer, una delle mie letture preferite).

Che percorso abbiamo fatto?

Prima di tutto ci siamo rivolti alla redazione chiedendo ai giornalisti di compilare un elenco delle fonti affidabili  che loro monitorano regolarmente. L’ idea era di costruire un corpus di fonti qualificate basandosi sui suggerimenti dei nostri specialisti interni. Techmeme e Mediagazer la chiamano  “leaderboard”  (qui e qui gli elenchi di siti specializzati e di media, ndr). Forse non avevamo il passo giusto, o siamo stati fraintesi, ma il nostro progetto ha ottenuto una tiepida accoglienza . Il nostro partner, la startup francese Syllabs‘, ha scelto invece una soluzione diversa, ricorrendo ad un’ analisi del flusso su Twitter.

Abbiamo preso gli account Twitter dei 72 nostri giornalisti più attivi estraendo le URL incorporate nei loro tweet. Questo primo passaggio ha prodotto circa 5.000 URL , ma la maggior parte di essi si è rivelata inutile perché, il più delle volte, i giornalisti linkavano articoli loro o dei loro colleghi. A quel punto gli ingegneri di Syllabs hanno avuto un’ altra idea e si sono messi a lavorare sui tweet degli account seguiti dai redattori. Abbiamo raccolto 872.000 URL. Dopo questo abbiamo fatto un altro filtraggio, mettendo al lavoro dei veri curator che andavano in cerca di fonti originali in giro per il web. E sono stati analizzati anche i retweet, che segnalano un sentimento di rilevanza/fiducia. Dopo una ulteriore analisi dei componenti dei tweet, le 872.000 URL sono state ridotte a meno di 400 fonti originali che sono diventate il leaderboard di Les Echos 360 (ora siamo a meno di 160) .

Costruire un corpus di fonti è una cosa, ma classificare gli articoli rispetto al loro peso nel ciclo dell’ informazione è tutta un’ altra storia . Ogni ora fra 1.500 e 2.000 articoli o notizie passano attraverso il processo di filtraggio che definisce la loro impronta semantica (con la tassonomia a loro associata) . Poi vengono aggregati in “cluster”. Alla fine i cluster vengono classificati in base a un’ analisi statistica del loro “segnale” nel flusso generale delle informazioni. Ogni “Clustering” (raccolta+ranking) contiene 400-500 cluster, un processo che spesso può sovraccaricare i nostri computer .

Nonostante le continue revisioni delle 19.000 righe di codice, il sistema è lungi dall’ essere a punto. Come prevedevamo d’ altronde. In effetti, esso ha bisogno di due tipi di accordature: uno per mantenere spettro di fonti sufficientemente ampio in modo da riflettere adeguatamente il ventaglio degli argomenti che vogliamo coprire. Con un avvertimento: la quantità non crea necessariamente qualità . Setacciare l’ effetto long tail delle fonti potenzialmente buone continua a rivelarsi difficile.

La seconda regolazione riguarda la necessità di trovare il giusto equilibrio tra tutti i parametri : frequenza di aggiornamento, ” indice di qualità ” delle fonti vari altri criteri che non voglio rivelare qui. Mi sembra che il paragone azzeccato sia quello con uno studio di registrazione. Trovare il sound giusto è difficile.

Ci sono voluti anni per Techmeme per raffinare il proprio algoritmo. E ci vorrà un po’ di tempo anche per Les Echos 360 – ed ecco quindi perché stiamo lanciando il sito in versione beta (una soluzione non troppo condivisa nel campo dei media). Nessuna sorpresa, un flusso giornalistico continuo è un obbiettivo estremamente difficile da raggiungere. Per quanto riguarda Techmeme e Mediagazer, nonostante i miglioramenti apportati da Gabe Rivera, i loro algoritmi sono “rettificati” da più di una dozzina di redattori (che addirittura riscrivono anche i titoli per renderli più espliciti e incisivi). Un equipaggio molto più leggero monitorerà Les Echos 360 attraverso un back- office che ci permetterà di cambiare le classifiche dei cluster e di eliminare gli elementi parassitari.

Per la divisione digitale di Les Echos, questo aggrefilter è una verifica sperimentale, un modo per imparare un insieme di tecnologie che consideriamo essenziali per il futuro dell’ azienda. Il settore dell’ informazione digitale sarà sempre più guidato da processi semantici, che  permetteranno agli editori di estrarre più valore dalle notizie, sia prodotte all’ interno che aggregate/filtrate.

Questo è particolarmente vero per un fornitore di informazione economica: più è specializzato il corpus delle fonti, maggiore è la necessità di elaborazione avanzata. Fortunatamente, è molto più facile da mettere a punto un aggrefilter per un campo specifico (logistica, clean -tech, M & A, affari legali …) che non per flussi più ampi e ‘’liquidi’’ ​di notizie generaliste.

Questo nuovo sito è solo la punta dell’iceberg. Abbiamo costruito questo motore per affrontare una vasta gamma di esigenze verticali, business-to-business. E vorrebbe essere una fonte di reddito concreta.