Gli uomini che hanno re-inventato il mondo (2)

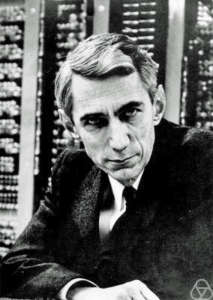

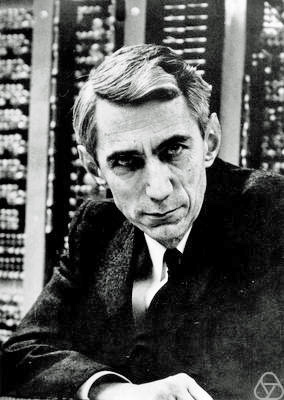

Non è esagerato affermare che Claude Shannon è stato il Padre dell’Era Informatica e che i suoi traguardi intellettuali sono da annoverare fra i più grandi del ventesimo secolo.

“Notices of the American Mathematical Societyâ€

Molto meno noto e famoso di Alan Turing, Shannon condivide con il matematico inglese percorsi simili, ricerche simili, scoperte simili e parimenti importanti. Pur non essendo conosciuto in modo così diffuso, come accaduto a Turing, anche grazie al recente film di cui è stato protagonista, l’ingegnere matematico americano, ha meriti simili a quelli di Turing, e come il matematico inglese ha letteralmente rivoluzionato il mondo moderno, dalle sue radici, e in modo totale e perenne. Shannon assieme a Turing e a Wiener ha letteralmente consegnato il mondo alla rivoluzione digitale, lo ha reso calcolabile, come ci è capitato di dire altre volte proprio su queste colonne. L’ingegnere americano ha formulato in particolare una teoria che ha reso possibile – forse a sua stessa insaputa, come vedremo più avanti – l’insolita e ignota commistione fra due mondi quello della matematica e quello della logica che ha portato alla teorizzazione e poi, alla vera e propria “realizzazione” del mondo moderno; quello in cui viviamo ogni giorno, a quell’era dell’informazione in cui siamo immersi quotidianamente.

Nella fase centrale della guerra, agli inizi del 1943, due studiosi con lo stesso atteggiamento mentale, Claude Shannon e Alan Turing, si incontravano tutti i giorni all’ora del tè nella caffetteria dei Bell Labs e non parlavano del loro lavoro, perché era segreto

Turing mostrò a Shannon un articolo che aveva scritto sette anni prima, con il titolo “On Computable Numbers”, sulla potenza e i limiti di una macchina di calcolo ideale. Parlarono di un altro argomento che stava molto a cuore a entrambi, la possibilità che le macchine imparassero a pensare. Shannon suggerì di dare in pasto a un cervello elettronico “cose culturaliâ€, per esempio musica, e fecero a gara nel lasciare le briglie sciolte all’immaginazione, con Turing che una volta ebbe a esclamare: “No, non mi interessa arrivare a un cervello potente. Quello che vorrei ottenere è soltanto un cervello mediocre, diciamo come quello del presidente dell’American Telephone and Telegraph Companyâ€. Era al limite della sfrontatezza parlare di macchine pensanti nel 1943, quando transistor e calcolatore elettronico erano ancora di là da venire. La visione che avevano in comune Shannon e Turing però non aveva nulla a che fare con l’elettronica: riguardava la logica.

(L’informazione James Gleick)

In accordo con le teorie di Turing e sviluppando in parte gli studi sulla crittografia che entrambi stavano seguendo, Shannon mettendo in relazione le sue ricerche, le sue competenze e alcune importanti intuizioni e scoperte, realizzate da altri scienziati del passato e del “suo” presente, fra cui l’inventore della cibernetica: Norbert Wiener; pochi anni dopo scrive e pubblica un documento che cambierà per sempre gli assetti planetari e la storia dell’Umanità . Il suo capolavoro, del 1948, lo stesso anno in cui un altro avvenimento scientifico rendeva possibile la costruzione di apparati di calcolo complessi – i computer – l’invenzione dei “transistor”; che si intitolava : “The Mathematical Theory of Communication”  gettava le basi per un campo di ricerca completamente nuovo: la teoria dell’informazione. Un campo di cui anche Shannon stesso sapeva ben poco. Come avrebbe ammesso, lui stesso, in epoca più tarda, e poco prima di perdere la memoria a causa del male che l’avrebbe a poco a poco reso inabile: l’Alzheimer. Un campo di studi in cui il concetto di informazione veniva definito, per la prima volta, in modo diverso e totalmente nuovo. In modo moderno.

Innanzitutto Shannon doveva estirpare il “significatoâ€: le virgolette in funzione di germicida sono sue. “Il ‘significato’ di un messaggio in genere è irrilevante,†diceva tranquillamente.

La provocazione mirava a presentare con estrema chiarezza le sue finalità . Shannon, per creare una teoria,

doveva requisire la parola informazione: “‘informazione’ qui, anche se è in relazione con il significato quotidiano della parola, non va confusa con quelloâ€. Come Nyquist e Hartley prima di lui, voleva lasciare da parte “i fattori psicologici†e concentrarsi solo su “quelli fisiciâ€. Ma se si separa l’informazione dal contenuto semantico, che cosa resta? Si potevano indicare alcune cose, e di primo acchito sembravano tutte paradossali. L’informazione è incertezza, sorpresa, difficoltà ed entropia:

- “L’informazione è strettamente associata all’incertezza.†L’incertezza, a sua volta, può essere misurata contando il numero dei messaggi possibili. Se è possibile un solo messaggio, non c’è incertezza e quindi non c’è informazione.

- Alcuni messaggi possono essere più probabili di altri, e l’informazione comporta sorpresa. La sorpresa è un modo di parlare di probabilità . Se la lettera che segue la t (in inglese) è h, non viene comunicata molta informazione, perché la probabilità di h è relativamente elevata.

- “Quel che è significativo è la difficoltà nel trasmettere il messaggio da un punto a un altro.†Forse sembra un po’ al contrario, oppure tautologico, come definire la massa in termini della forza necessaria per spostare un oggetto. Ma la massa può essere definita in questo modo.

- L’informazione è entropia. Questa è la nozione più strana e più potente. L’entropia (già un concetto difficile e mal compreso) è una misura del disordine in termodinamica, la scienza del calore e dell’energia.

il messaggio era difficile da riassumere, ma era un perno attorno al quale il mondo cominciò a girare. Come il transistor, anche questo sviluppo chiamava in causa un neologismo: la parola bit

(L’informazione James Gleick)

Fondamentale fra le altre molteplici teorie introdotte in questo colossale lavoro di Shannon, l’introduzione di una nuova unità di misura, il Bit, come una quantità ben definita. La prima comparsa in letteratura del Bit, si ebbe proprio nel fondamentale lavoro di Shannon, il quale ne attribuì la paternità al matematico americano, John W. Tukey, collega di Shannon per un periodo della sua vita, ai Bell Labs,  e poi professore alla Princeton University. Bit è la contrazione di binary digit (cifra binaria). E da quel momento, dopo la pubblicazione del documento di Shannon, è, anche, diventata per tutti, qualcosa d’altro, di diverso, unico e nuovo: l’unità di misura dell’informazione.

Un numero (ora lo sappiamo) è informazione. Quando noi, eredi di Shannon, pensiamo l’informazione nella sua forma più pura, possiamo immaginare una successione di 0 e 1, un numero binario.

La teoria di Shannon gettò un ponte fra informazione e incertezza; fra informazione ed entropia; e fra informazione e caos. Ci ha portato fino ai compact disc e ai fax, ai computer e al ciberspazio, alla legge di Moore e a tutte le Silicon Valley del mondo. Era nata l’elaborazione delle informazioni, con la loro memorizzazione e il loro reperimento.

Il ruolo dell’informazione cresce al di là di quanto chiunque possa pensare, cresce addirittura troppo. “TMIâ€, si dice oggi, too much information. Abbiamo stress da informazione, ansia da informazione, eccesso di informazione. Abbiamo incontrato il Diavolo del sovraccarico di informazione e i suoi diabolici assistenti, i virus informatici, il segnale di occupato, il collegamento interrotto e la presentazione di PowerPoint. Anche tutto questo è dovuto, in modo contorto, a Shannon. Tutto è cambiato molto in fretta. John Robinson Pierce (l’ingegnere dei Bell Labs che ha escogitato la parola transistor) rifletteva: “È difficile figurarsi il mondo prima di Shannon, come doveva sembrare a quelli che ci vivevano. È difficile ritrovare l’innocenza, l’ignoranza e la mancanza di comprensioneâ€.

(L’informazione James Gleick)

Ma Shannon non è stato solo un matematico di genio, la sua componente ingegneristica lo ha reso anche un inventore poliedrico e uno dei primi scienziati a studiare l’intelligenza artificiale. Non solo, unendo le sue ricerche in tale campo alle sue competenze tecniche, Shannon è stato anche uno dei primi scienziati in grado di costruire un robot intelligente. Il “celebre”, topo meccanico di Shannon, denominato Teseo.

Ma Shannon non è stato solo un matematico di genio, la sua componente ingegneristica lo ha reso anche un inventore poliedrico e uno dei primi scienziati a studiare l’intelligenza artificiale. Non solo, unendo le sue ricerche in tale campo alle sue competenze tecniche, Shannon è stato anche uno dei primi scienziati in grado di costruire un robot intelligente. Il “celebre”, topo meccanico di Shannon, denominato Teseo.

Negli anni cinquanta, lo stato dell’arte era Teseo, un topo autonomo a grandezza naturale costruito da Claude Shannon ai Bell Labs e alimentato da un banco di relè telefonici. L’originale Teseo, l’eroe greco, entrò nel labirinto per uccidere il Minotauro. Il topo Teseo aveva ambizioni più modeste: entrò in un labirinto da tavolo composto da venticinque quadrati per trovare un pezzo di formaggio. All’inizio procedette per tentativi e riuscì a trovare il pezzo di formaggio. Dopo il trionfo iniziale, riuscì a trovare il percorso per uscire da qualsiasi punto del labirinto, senza mai compiere errori

(Numeri intelligenti Nick Polson James Scott)

Nel concludere la riflessione su un altro grande del nostro tempo, un contemporaneo, non privo – come ciascuno di noi – di difetti, vogliamo riportarVi, un breve estratto da una dichiarazione di Shannon, in cui il matematico e ingegnere americano, oramai famoso e celebrato nel mondo, probabilmente sentendo venire meno la sua lucidità in seguito alla malattia che lo stava affliggendo, prova a chiarire nel miglior modo possibile, quali fossero le sue intenzioni più sincere quando aveva scritto il documento di sintesi delle sue teorie e dei suoi studi nel 1948, quel “A mathematical theory of comunication”, che gli procurò fama e considerazione nel mondo accademico e non solo:

Alla fine degli anni Ottanta, mentre la sua memoria cominciava ad affievolirsi, insieme alla moglie Betty, analista numerica conosciuta ai Laboratori Bell e sposata nel 1949, Shannon parlò candidamente della sua teoria e delle sue finalità che, come lui stesso, erano piuttosto modeste e riservate. Difese la sua decisione di staccare la teoria tecnica dell’informazione dagli annosi dibattiti filosofici sul significato e dalle moderne teorie semantiche, tutti irrilevanti per il problema ingegneristico, ma fece una storica distinzione che avrebbe risparmiato parecchia confusione inutile e trambusto scientifico. Shannon negò la paternità della cosiddetta “teoria dell’informazione”.

“Innanzitutto l’avevi chiamata teoria della comunicazione,” ricordò Betty Shannon al marito. “Non l’avevi battezzata teoria dell’informazione”.

“Sì, pensavo che la comunicazione fosse questione di spostare bit da qui a là , che essi siano parte della Bibbia o la direzione in cui viene lanciata una moneta”, confermò Shannon. La sua posizione, a quel punto, era pressoché identica a quella di von Foerster quattro decenni prima.

Betty testimoniò l’angoscia di Shannon quando scienziati molto lontani dal campo dell’ingegneria della comunicazione saltarono sul “carro dell’informazione”, come lo chiamava lui, costringendolo a osservare il suo lavoro deragliare dai binari della teoria tecnica che aveva propugnato. “Nel corso del tempo questo ti ha infastidito diverse volte, ma a quel punto la faccenda non era più fra le tue mani”, disse Betty.

Shannon riaffermò i limiti che aveva messo al suo lavoro, che confinavano la sua teoria a qualcosa di specifico e puramente tecnico, privo delle più ampie aspirazioni filosofiche e connessioni sociali che caratterizzavano la missione di Wiener e la sua visione della cibernetica. “La teoria concerne solo lo spostamento di bit da un punto a un altro”, ripeté Shannon. “Questa è la sua parte di comunicazione, ciò che cercavano di fare gli ingegneri della comunicazione. L’informazione, ciò cui si collega il significato, viene dopo, è il passo successivo, e non è una preoccupazione dell’ingegnere, anche se è interessante parlarne”.

(L’eroe oscuro dell’età dell’informazione F.Conway J.Siegelman)

Dichiarazioni clamorose, mai abbastanza sottolineate e rese note, e non a caso inserite in un libro dedicato a Norbert Wiener, ovvero al padre della cibernetica, dai cui studi Shannon ha preso spunto più volte, per comporre le sue teorie. Dichiarazioni che rimandano a molti annosi dibattiti fra scienziati e filosofi, ancora attualissimi, sulla “sostanza delle cose”, sul mondo calcolabile, sulla presunta – molto presunta – neutralità della tecnologia; sull’intelligenza umana e artificiale e sulle macchine che “aiutano” l’uomo. Noi non abbiamo risposte, ma solo molte domande e spunti di riflessione che in genere ci vengono suggeriti da persone molto più competenti e informate di noi stessi. Per questo anche quest’oggi nel salutarci vorremmo lasciarVi con una citazione. Un ragionamento filosofico che ci convince molto e che estraiamo da un nostro post precedente intitolato: L’unico algoritmo buono e l’algoritmo morto. Un post che risale al 2017. Grazie per l’attenzione e buona settimana ;)

La risposta è stata individuata già nel ‘700 da Kant (La pace perpetua): se gli chiedessimo cos’è la modernità , ci direbbe che la scommessa della modernità è di cercare di mettere insieme il patrimonio conoscitivo, cui non possiamo rinunciare – compreso l’algoritmo – , e l’incremento delle libertà dei diritti. Ci dimentichiamo che nell’esplosione della modernità la sfida è proprio questa: l’incremento della libertà deve andare di pari passo con l’incremento della conoscenza.

(Fabio Minazzi ordinario di filosofia Università Insubria)